Тысячи учёных, в чью компетенцию входит работа над созданием искусственного интеллекта (ИИ), заявили, что не будут участвовать в проектах по производству автономных роботов-убийц, которые могут самостоятельно, без надзора со стороны человека, принимать решение и атаковать людей.

Демис Хассабис из Google DeepMind, Илон Маск из SpaceX и ещё более чем 2400 исследователей подписали обязательство, призванное удержать военные фирмы и страны от создания смертоносных автономных систем оружия.

Этот шаг в очередной раз подчёркивает опасность идеи о передаче в руки машин, обогащённых ИИ, возможности принимать решения о жизни и смерти. Участники кампании сочли необходимым призвать к превентивному запрету на технологии, которые могут привести к появлению оружия массового уничтожения нового поколения.

Инициаторы соглашения призывают правительство согласовать нормы, законы и правила, которые заклеймят навеки и фактически запретят разработку роботов-убийц. Пока такие меры не приняты, подписавшие соглашение стороны обязуются «не участвовать и не поддерживать разработку, производство, торговлю или применение смертоносного автономного оружия».

Роботы-«призывники»

Военные — в рядах крупнейших спонсоров проекта по развитию роботов с ИИ. Они же, одновременно, являются «усыновителями» собственно самой технологии искусственного интеллекта. Роботы с ИИ, поступив на боевые посты, могут выполнять полёты над вражеской территорией, ориентироваться на суше и осуществлять подводное патрулирование.

Идёт поиск более совершенных систем вооружения. Так, министр обороны Великобритании Гэвин Уильямсон 16 июля этого года обнародовал план (на 2 млрд фунтов стерлингов) для нового истребителя RAF Tempest, который сможет летать без пилота.

Однако для большинства исследователей, передача машинам полномочий самостоятельно выбирать, кого «казнить» и кого «помиловать», находится за гранью представлений о морали.

Министры Соединенного Королевства поспешили оправдаться, заявив, что Великобритания не разрабатывает автономные системы смертоносного оружия. Но быстрый прогресс в ИИ означает лишь одно: появилась возможность создавать современное оружие, которое может идентифицировать, отслеживать и стрелять по людям, не согласовывая каждый свой шаг с «командиром»-человеком.

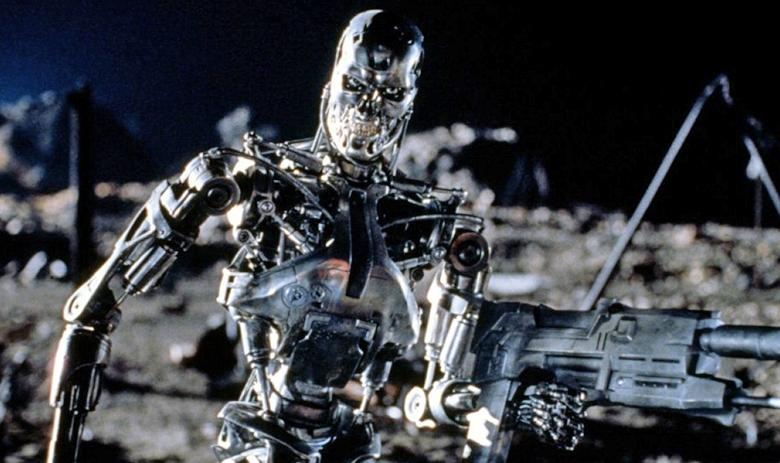

Кадр из фильма «Я, робот»

Кадр из фильма «Я, робот»

«Автономное оружие неприемлемо, и это должно стать международной нормой», — считает Тоби Уолш, профессор ИИ в университете нового Южного Уэльса в Сиднее, также подписавший соглашение.

«Мы не сможем удержать конкретного человека от создания автономного оружия, также как мы не в состоянии удержать кого-либо от создания химического оружия», — добавил Уолш. — «Но, если мы не хотим, чтобы государства-изгои или же террористы имели лёгкий доступ к автономному оружию, мы должны убедиться, что они не продаются открыто компаниями по поставкам вооружений».

Учёные, безусловно, могут принять решение не работать над автономным оружием. Но то, что сделают люди с данными, которые уже были опубликованы — вне зоны влияния разработчиков.

Технологии на службе роботов-убийц

Сразу несколько компаний попали в жернова «обратной реакции» на технологии, которые они разработали и представили правительственным учреждениям.

Кадр из фильма «Трансформеры»

Кадр из фильма «Трансформеры»

Компанию Google встретил огонь из-за проекта Maven Pentagon contract. Проект Maven («Знаток») предполагает, что американские учёные и военные совместно анализируют съёмки, сделанные беспилотниками армии США. В программе применено машинное обучение, наравне с ИИ. ИИ анализирует видео, распознаёт объекты и помечает их для эксперта, который позже изучает их. По замыслу авторов, аналитикам это поможет обрабатывать вдвое, а то и втрое больше данных. Однако очень скоро этот совместный проект окрестили «заработком на войне», и кончилось всё тем, что Google решила не продлевать договор.

Точно также критикуют компанию Amazon за обмен технологией распознавания лиц с правоохранительными органами.

И только Илон Маск не успел испачкаться во всей этой истории. Зато активно попиарился, в 2015 году пожертвовав $ 10 млн для исследовательской программы, направленной на обеспечение того, чтобы искусственный интеллект был полезен человечеству. Но уже год спустя Маск и ещё более сотни специалистов из 26 стран подписали открытое письмо Организации объединенных наций с призывом запретить автономное оружие, сообщает The Guardian. Авторы письма обеспокоены возможным началом новой гонки вооружений и призывают приложить все усилия, чтобы предотвратить разработку автономного оружия и защитить людей от его применения.

Но не поздно ли подписывать всякого рода соглашения? Не открыт ли ящик Пандоры?

Михаил Ходарёнок, военный эксперт

Заявления учёных из разных стран по поводу того, что они якобы не будут разрабатывать эти системы, — не более, чем слова. За рубежом уже многие наработки в этом плане активно используются, например, в истребителе F-35 Lightning II — американской машине пятого поколения — лётчику помогают принимать правильные решения соответствующие системы искусственного интеллекта. Аналогичные разработки есть и у нас, целые подразделения, и этому вопросу уделяется много внимания. Считается, что после изобретения пороха и ядерного оружия, искусственный интеллект будет третьей революцией в военном деле — вот насколько серьёзно ставится вопрос у нас в вооружённых силах.

Конечно, мы идём теми же путями, что и США. Наверняка соответствующие системы будут и в нашем истребителе пятого поколения, и во многих перспективных системах вооружения и военной техники. Если говорить об определении искусственного интеллекта, то их, конечно, очень много, но самое простое из них — когда человек общается и не может понять: он общается с машиной или с человеком? Обеспокоенность на тему того, что машина сможет сама принимать решение о лишении человека жизни, есть. Но это никак не остановит развитие систем вооружения и военной техники, которые будут создаваться с учётом применения этих систем. Другое дело, что будут использоваться какие-то защитные механизмы. Только человек должен принимать решение о боевом применении того или иного оружия. Чтобы этой привилегии у машины не возникло, её возможности надо ограничить.

Валерий Коровин, директор Центра геополитических экспертиз

«Вопрос искусственного интеллекта представляет из себя серьёзную проблему для человечества. На эту тему есть много исследований, художественных произведений. Очевидно, что такая сложная самостоятельная вещь как искусственный интеллект рано или поздно выйдет из-под человеческого контроля. И это будет рационально с точки зрения ИИ, потому что человек сам по себе — существо не рациональное, скорее иррациональное. Большое количество несоответствий идеальной схеме, которая заложена в качестве программы в искусственный интеллект, конечно, в итоге приведёт к выходу его из-под контроля. Соответственно, в вооруженных силах использовать его нельзя, это крайне опасно и в целом укладывается в тенденцию посгуманизма — расчеловечивания: в жизни человека становится все меньше человека. Несмотря на внешне кажущиеся преимущества использования искусственного интеллекта в подразделениях ВС, в долгосрочной перспективе это не предвещает человечеству ничего, кроме проблем, хаоса и тяжелых последствий.

Айзек Азимов, писатель. Рассказ «Хоровод» (1942), отрывок.

Начнём с Трёх Основных Законов Роботехники — трёх правил, которые прочно закреплены в позитронном мозгу.

Первое: робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

Второе: робот должен повиноваться всем приказам, которые даёт человек, если эти приказы не противоречат Первому Закону.

Третье: робот должен заботиться о своей безопасности в той мере, в какой это не противоречит Первому и Второму Законам.